Bir e-ticaret yöneticisi olarak her gün sayısız metrikle boğuşuyorsunuz: dönüşüm oranları, sepet terk etme oranları, oturum başına gelir, reklam harcamasının getirisi... Web sitenizin organik performansını artırmak için de elinizden geleni yapıyorsunuz. Anahtar kelime araştırması, rakip analizi, kaliteli içerik üretimi, on-page SEO ayarları, backlink çalışmaları... Tüm bu çabalara rağmen, bazen sonuçlar beklentilerinizi karşılamaz. Büyük bir hevesle satışa sunduğunuz yeni sezon ürünleri bir türlü Google'da görünmezken, yıllar önce stoktan kaldırdığınız bir ürünün sayfası hala trafik alıyor olabilir. Peki neden? Çünkü siz sitenize "dışarıdan" bakıyorsunuz. Gerçekte nelerin olup bittiğini, yani arama motoru botlarının sitenizi nasıl gördüğünü ve gezdiğini bilmiyorsunuz.

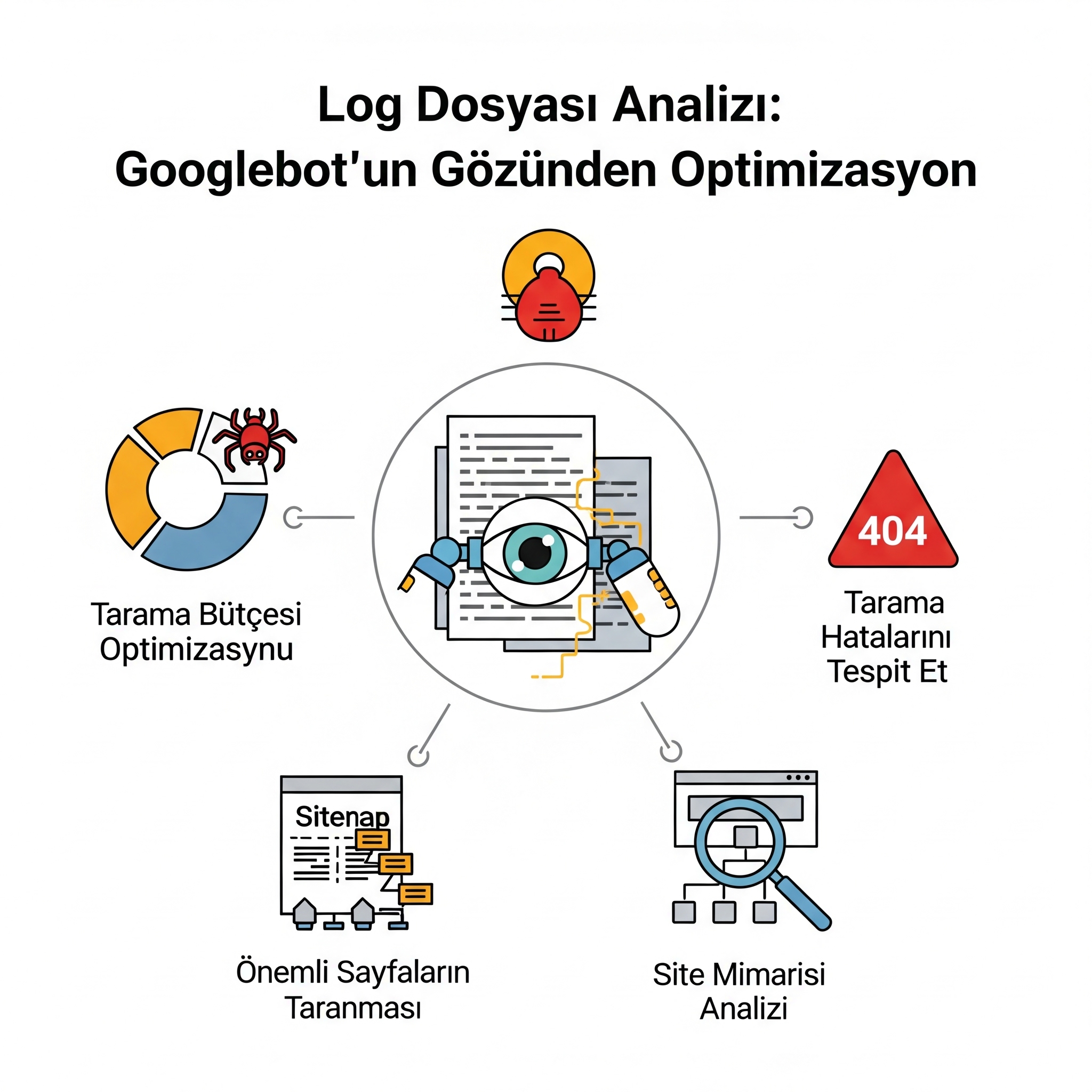

İşte bu noktada, teknik SEO'nun en güçlü ama en az kullanılan silahlarından biri devreye giriyor: Log dosyası analizi (Log file analysis). Bu, tahmin yürütmeyi bırakıp doğrudan kanıtlarla hareket etmenizi sağlayan bir yöntemdir. Sitenizin sunucu kayıtlarını inceleyerek, Googlebot'un ve diğer arama motoru botlarının sitenizde attığı her adımı, ziyaret ettiği her URL'yi, karşılaştığı her hatayı ve hangi sayfalara ne kadar değer verdiğini birinci elden görmenizi sağlar. Bu rehber, log dosyası analizinin ne olduğunu, e-ticaret siteniz için neden hayati önem taşıdığını ve bu teknik verileri nasıl somut, gelir artırıcı aksiyonlara dönüştürebileceğinizi en ince ayrıntısına kadar anlatmak için hazırlandı. Perde arkasına geçip sitenizi Google'ın gözünden görmeye hazır olun.

Log Dosyası Analizi Tam Olarak Nedir?

Birisi (insan bir kullanıcı veya bir bot) web sitenizdeki bir sayfayı ziyaret ettiğinde, sunucunuz bu istekle ilgili küçük bir kayıt oluşturur. Bu kayıtların tutulduğu dosyalara "log dosyaları" veya "sunucu logları" denir. Log dosyası analizi, bu ham veri dosyalarını toplayıp, özellikle Googlebot gibi arama motoru botlarının aktivitelerine odaklanarak analiz etme sürecidir.

Bu, Google Search Console'un sağladığı özet verilerden çok daha derindir. GSC size bir sonuç raporu sunarken, log dosyaları size o sonuca giden yolun tamamını, yani ham verinin kendisini verir. Bu, Google'ın sitenizle olan her etkileşiminin sansürsüz ve filtrelenmemiş kaydıdır.

E-Ticaret Siteleri İçin Log Analizi Neden Hayati Bir Stratejidir?

"Bu kadar teknik detaya neden ihtiyacım var?" diye düşünebilirsiniz. Cevap, doğrudan kârlılığınızla ilgilidir. Büyüme odaklı bir e-ticaret yöneticisi için log analizi, şu kritik sorulara net cevaplar verir:

- Tarama Bütçesi (Crawl Budget) Optimizasyonu: Google'ın her site için ayırdığı bir "tarama bütçesi" vardır. Bu, Googlebot'un sitenizde belirli bir süre içinde tarayacağı sayfa sayısıdır. Eğer bu bütçe, önemsiz, yinelenen veya hatalı sayfalarda harcanırsa, Googlebot yeni ve önemli ürün sayfalarınızı taramaya fırsat bulamayabilir. Log analizi, bu bütçenin nereye harcandığını gösteren tek kesin yöntemdir.

- Kritik İndeksleme Sorunlarını Tespit Etme: "Bu ürün sayfasını bir ay önce yayınladım, neden hala Google'da yok?" sorusunun cevabı log dosyalarındadır. Belki de Googlebot o sayfaya hiç ulaşamıyor veya ulaştığında bir hatayla karşılaşıyor.

- Gizli Teknik Hataları Ortaya Çıkarma: Sitenizde kullanıcıların görmediği ama Googlebot'un sürekli karşılaştığı binlerce 404 (bulunamadı) hatası veya yönlendirme döngüsü olabilir. Bu hatalar, sitenizin SEO sağlığını yavaş yavaş kemiren sessiz katillerdir.

- Site Mimarisi ve İç Linklemenin Etkinliğini Doğrulama: Sitenizin hangi bölümlerinin (kategoriler, markalar, blog) Google tarafından daha önemli görüldüğünü ve daha sık tarandığını anlayabilirsiniz. Bu bilgi, iç linkleme stratejinizi şekillendirmek için bir altın madenidir.

Hipotetik Senaryo: TeknoDepo'nun "Görünmez" Ürünleri

Zeynep Hanım, Türkiye'nin önde gelen online elektronik mağazalarından "TeknoDepo"nun e-ticaret müdürü. Şirket, yüksek kâr marjlı yeni "8K Televizyonlar" kategorisini büyük bir lansmanla duyurdu. Kategoriye özel içerikler yazıldı, sitenin ana sayfasından linkler verildi. Ancak aradan haftalar geçmesine rağmen, ne kategori sayfası ne de ürünler "8K TV fiyatları" gibi önemli aramalarda görünmüyordu. Daha da kötüsü, Google Analytics verileri, üç yıl önce stoktan kalkan "eski model DVD oynatıcı" sayfalarına hala ciddi bir bot trafiği geldiğini gösteriyordu. Zeynep Hanım, tarama bütçesinin yanlış yerlerde harcandığından şüpheleniyordu ama elinde kanıt yoktu. İşte bu, onu log dosyası analizinin derinliklerine inmeye iten andı.

Adım 1: Log Dosyalarını Anlamak ve Sunucudan Almak

Analize başlamadan önce, ne aradığınızı ve onu nereden bulacağınızı bilmelisiniz.

Bir Log Satırı Neye Benzer?

Ham bir log dosyası ilk bakışta anlamsız bir metin yığını gibi görünebilir. Ancak her satır, yapısal bir bilgi içerir. Tipik bir log satırı şöyledir:

123.123.123.123 - - [01/Jul/2025:10:30:01 +0300] "GET /kadin/elbise/yeni-sezon-cicekli-elbise HTTP/1.1" 200 1512 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Bunu parçalara ayıralım:

- 123.123.123.123: İsteği yapanın IP adresi. Googlebot'un bilinen IP adreslerinden biri olup olmadığını buradan anlarız.

- [01/Jul/2025:10:30:01 +0300]: İsteğin yapıldığı tam tarih ve saat (timestamp).

- "GET /kadin/elbise/yeni-sezon-cicekli-elbise HTTP/1.1": İstenen dosya/URL. Analizin kalbi burasıdır.

- 200: Sunucunun isteğe verdiği cevap olan HTTP Durum Kodu. (200: Başarılı, 404: Bulunamadı, 301: Kalıcı Yönlendirme vb.)

- 1512: Dönen dosyanın boyutu (byte cinsinden).

- "Mozilla/5.0 (compatible; Googlebot/2.1; ...)": İsteği yapanın kimliğini belirten User-Agent. Bizim için en önemli kısım Googlebot ibaresidir.

Log Dosyalarını Nasıl Elde Edersiniz?

Bu genellikle sürecin en zorlu kısmı gibi görünse de aslında oldukça basittir.

- Hosting Firmanızla İletişime Geçin: En kolay yol, hosting sağlayıcınızın teknik destek ekibine bir e-posta veya ticket göndermektir. Sitenizin "ham erişim loglarına (raw access logs)" ihtiyacınız olduğunu belirtin. Genellikle size bu dosyaları indirebileceğiniz bir FTP adresi veya kontrol paneli linki sağlarlar.

- Kontrol Panelinizi (cPanel, Plesk vb.) Kontrol Edin: Çoğu hosting firması, kontrol panelinizde "Loglar", "Raw Access" veya "Metrics" gibi bir bölüm sunar. Buradan log dosyalarınızı .gz formatında sıkıştırılmış olarak indirebilirsiniz.

Önemli Not: Mutlaka filtrelenmemiş logları isteyin. Bazı sağlayıcılar, işleri basitleştirmek için sadece insan trafiğini gösteren özet raporlar sunar. Sizin ise Googlebot'un aktivitelerini içeren ham verilere ihtiyacınız var.

Adım 2: Analiz Başlıyor: Log Verilerinde Hazine Avı

Ham log dosyalarını elinize aldınız. Şimdi milyonlarca satır arasından değerli bilgileri çıkarma zamanı. İşte odaklanmanız gereken kilit noktalar:

1. Googlebot'un Tarama Sıklığı ve Öncelikleri

Bu analiz, Google'ın sitenizde en çok hangi bölümleri değerli bulduğunu gösterir.

- Hangi Dizinler En Çok Taranıyor? Googlebot tarama bütçesinin %70'ini /blog/ dizininde mi, yoksa /urunler/ dizininde mi harcıyor? Eğer ürünleriniz yerine blog yazılarınız daha çok taranıyorsa, bu bir strateji değişikliği sinyali olabilir.

- En Önemli Sayfalarınız Taranıyor mu? Yüksek kâr marjlı, stokta olan, en popüler kategorileriniz ve ürünleriniz ne sıklıkla taranıyor? Eğer ayda bir veya daha az taranıyorlarsa, Google'ın gözünde yeterince önemli değiller demektir.

- Tarama Sıklığı: Siteniz toplamda günde kaç Googlebot ziyareti alıyor? Bu sayının zamanla artması, sitenizin otoritesinin arttığının bir işaretidir.

TeknoDepo Senaryosu - İlk Bulgular: Zeynep Hanım, bir log analiz aracı kullanarak yaptığı ilk incelemede şok edici bir gerçekle karşılaştı. Googlebot'un tarama bütçesinin %30'u, ?renk=siyah&marka=x&sirala=fiyat-artan gibi parametreler içeren, sonsuz sayıda üretilebilen filtrelenmiş kategori URL'lerinde harcanıyordu. Bütçenin %20'si ise artık var olmayan eski DVD oynatıcı sayfalarında, yani 404 Not Found hatası veren URL'lerde boşa gidiyordu. Yeni ve önemli "8K Televizyonlar" kategorisi ise tüm tarama bütçesinin sadece %1'ini alıyordu. Sorunun kaynağı artık netti.

2. HTTP Durum Kodlarının Dili

Durum kodları, Googlebot'un sitenizle olan iletişiminin sonucunu özetler.

- 200 OK (Başarılı): Hangi değerli sayfalarınızın sorunsuzca tarandığını gösterir. Ama dikkat: Eğer önemsiz sayfalarınız sürekli 200 kodu alıyorsa, bu da bir tarama bütçesi israfıdır.

- 301 Kalıcı Yönlendirme: Bu yönlendirmeler normaldir, ancak Googlebot'un bir sayfaya ulaşmak için 2-3 veya daha fazla yönlendirmeden (redirect chain) geçtiğini görürseniz, bu hem tarama bütçesini israf eder hem de sayfa otoritesini azaltır.

- 404 Bulunamadı: Googlebot'un hangi kırık linklere (dahili veya harici) tıkladığını gösteren bir altın madenidir. Özellikle yüksek sayıda tarama alan 404 sayfaları, acilen düzeltilmesi gereken sorunlardır.

- 5xx Sunucu Hatası: Bunlar en kritik hatalardır. Googlebot bir sayfayı taramaya çalıştığında sunucunuzun çöktüğünü veya bir hata verdiğini gösterir. Eğer önemli sayfalarınızda sıkça 5xx hatası alıyorsanız, Google o sayfaları taramaktan vazgeçebilir.

3. Tarama Bütçesi (Crawl Budget) İsraf Noktaları

Log analizi, bütçenizi nerede boşa harcadığınızı net bir şekilde ortaya koyar:

- Filtreleme ve Sıralama Parametreleri: E-ticaret sitelerinin en büyük sorunudur. ?fiyat=100-200 gibi URL'ler, Google için aynı sayfanın binlerce kopyasını oluşturur.

- Oturum ID'leri (Session IDs): URL yapısına eklenen kullanıcıya özel kimliklerdir ve her ziyaret için farklı bir URL oluşturarak bütçeyi tüketirler.

- Test veya Geliştirme Ortamları (Staging): Eğer test sunucunuz yanlışlıkla taranabilir durumdaysa, Googlebot değerli bütçesini orada harcayabilir.

- Sonsuz Döngüler: Kötü yapılandırılmış bir takvim veya arşiv sayfası, Googlebot'u sonsuz bir tarama döngüsüne sokabilir.

Adım 3: Analizden Aksiyona: Bulguları SEO Stratejisine Dönüştürmek

Verileri toplamak işin yarısıdır. Asıl değer, bu verileri kullanarak somut adımlar atmaktan gelir.

Sorun: Parametreli URL'ler bütçeyi tüketiyor.

Aksiyon: robots.txt dosyanızı düzenleyerek bu parametrelerin (?renk=, ?sirala= vb.) taranmasını engelleyin (Disallow: /*?renk=). Ayrıca, Google Search Console'daki URL Parametreleri aracını kullanarak Google'a bu parametreleri nasıl işlemesi gerektiğini söyleyin.

Sorun: Googlebot, 404 hatası veren sayfalara çok fazla uğruyor.

Aksiyon: Bu 404 hatalarına link veren dahili sayfaları tespit edip düzeltin. Eğer kaldırılan sayfanın değerli bir alternatifi varsa, 301 yönlendirmesi yapın. Eğer sayfa kalıcı olarak kaldırıldıysa ve bir alternatifi yoksa, 410 Gone durum kodu döndürmek, Google'a "bu sayfayı bir daha arama" demenin en net yoludur.

Sorun: Yeni ve önemli ürün sayfaları taranmıyor.

Aksiyon: Tarama bütçesini boşa harcayan sorunları çözdükten sonra, bu önemli sayfalara sitenizin otoriter sayfalarından (ana sayfa, ilgili kategori sayfaları, popüler blog yazıları) daha fazla iç link verin. XML site haritanızın güncel olduğundan ve bu sayfaları içerdiğinden emin olun.

Sorun: Googlebot sık sık 5xx sunucu hataları alıyor.

Aksiyon: Bu durumu acilen geliştirme ekibiniz veya hosting firmanızla paylaşın. Sunucu kapasitesinin artırılması, veritabanı sorgularının optimize edilmesi veya sunucu yapılandırma hatalarının düzeltilmesi gerekebilir.

Bu derinlemesine analiz ve ardından gelen teknik uygulama süreci, yoğun bir e-ticaret operasyonunu yönetirken göz korkutucu olabilir. Milyonlarca log satırını analiz etmek, doğru araçları kullanmak ve bulguları hatasız bir şekilde teknik aksiyonlara dönüştürmek uzmanlık gerektirir. İşte bu noktada Solviera Dijital'in tecrübeli teknik SEO ekibi devreye girer. Ham sunucu loglarınızı alıp onları anlaşılır raporlara ve önceliklendirilmiş aksiyon planlarına dönüştürüyoruz. Tarama bütçesi optimizasyonundan en karmaşık indeksleme sorunlarının çözümüne kadar tüm süreci yöneterek, sizin en değerli varlığınız olan zamanınızı işinizi büyütmeye odaklamanızı sağlıyoruz.

Log Dosyası Analizi İçin Popüler Araçlar

- Screaming Frog SEO Log File Analyser: Masaüstü tabanlı, en popüler ve kullanıcı dostu araçlardan biridir.

- ELK Stack (Elasticsearch, Logstash, Kibana): Çok büyük siteler için güçlü, açık kaynaklı ve ölçeklenebilir bir çözümdür.

- Splunk / Datadog: Kurumsal düzeyde, sadece SEO değil genel sunucu izlemesi için kullanılan gelişmiş platformlardır.

Sonuç

Log dosyası analizi, bir e-ticaret sitesi için artık lüks değil, bir zorunluluktur. SEO stratejinizi "umarım Google bu sayfayı sever" varsayımından, "Google'ın bu sayfayı tam olarak ne zaman, ne sıklıkla taradığını ve ne sonuç aldığını biliyorum" kesinliğine taşıyan köprüdür. Tarama bütçenizi optimize etmek, Google'ın en kârlı ürünlerinize odaklanmasını sağlamak, teknik hataları rakiplerinizden önce bulup düzeltmek ve nihayetinde organik trafiğinizi ve gelirinizi artırmak için yapabileceğiniz en etkili yatırımlardan biridir. Sitenizin kapısını Googlebot'a açın ve onun size anlattıklarını dinleyin; duyduklarınız sizi daha kârlı bir geleceğe taşıyacaktır.

Sıkça Sorulan Sorular

Hayır, aynı şey değildir. GSC Tarama İstatistikleri raporu, log verilerinin Google tarafından işlenmiş bir özetidir ve faydalı bir genel bakış sunar. Ancak log dosyası analizi, size ham, filtrelenmemiş verinin tamamını verir. Bu sayede sadece Googlebot'un değil, Bingbot, YandexBot gibi diğer botların aktivitelerini, taranan resim ve CSS dosyalarını, spesifik URL'lerdeki yönlendirme zincirlerini ve GSC'nin göstermediği daha nice detayı görebilirsiniz.

Bu, sitenizin trafiğine ve neyi araştırdığınıza bağlıdır. Genel bir kural olarak, en az bir aylık veri analiz etmek, mevsimsel veya haftalık dalgalanmaları elemek için iyi bir başlangıç noktasıdır. Eğer belirli bir sorunu (örneğin bir site taşıması sonrası) inceliyorsanız, olaydan önceki ve sonraki birkaç haftalık veriyi karşılaştırmak daha anlamlı olacaktır.

Büyük ve sık güncellenen e-ticaret siteleri için üç ayda bir (her çeyrekte) log analizi yapmak idealdir. Daha küçük veya daha az dinamik siteler için altı ayda bir veya yılda bir yapmak yeterli olabilir. Ancak büyük bir site değişikliği, site taşıması veya açıklanamayan bir trafik düşüşü sonrasında mutlaka yapılmalıdır.

Evet. Küçük sitelerin tarama bütçeleri de küçüktür, bu nedenle bu bütçenin verimli kullanılması daha da önemlidir. Küçük bir sitede bile Googlebot'un zamanını yanlış sayfalarda harcaması, önemli sayfaların indekslenmesini geciktirebilir. Log analizi, siteniz küçükken doğru alışkanlıkları kazanmanızı ve büyüdükçe karşılaşacağınız sorunları öngörmenizi sağlar.

Evet, kesinlikle. Özellikle Bing gibi diğer arama motorlarından da trafik alıyorsanız, Bingbot'un davranışlarını analiz etmek önemlidir. Ayrıca, AhrefsBot, SEMrushBot gibi SEO araçlarının botlarının sitenizi ne sıklıkla taradığını görmek de faydalı olabilir. Bazen bu araçların agresif taramaları sunucu kaynaklarını tüketebilir ve log analizi bu durumu tespit etmenizi sağlar.

İşletmenizi Bir Sonraki Seviyeye Taşımaya Hazır Mısınız?

Solviera'nın bütünsel teknoloji çözümleri hakkında daha fazla bilgi almak ve işletmenize özel bir analiz için proje danışmanlarımızla bugün iletişime geçin!